Google sta testando l’uso di sistemi di intelligenza artificiale per la generazione automatica dei titoli visualizzati in Google Discover, il feed che aggrega notizie e contenuti personalizzati per milioni di utenti.

L’iniziativa, come segnalato da The Verge, sta però producendo esiti problematici: titoli errati, fuorvianti o addirittura completamente inventati rischiano di minare la fiducia degli utenti sia nei confronti della piattaforma sia verso le testate coinvolte.

La funzione in sperimentazione ha l’obiettivo dichiarato di rendere più immediata la comprensione dei contenuti, facilitando l’esplorazione delle notizie senza che gli utenti debbano effettuare ricerche manuali. Tuttavia, in alcuni casi, l’automazione si sarebbe rivelata fallace. Alcuni titoli generati dall’AI di Google risultano infatti imprecisi o privi di collegamento con l’articolo originale, con il rischio non solo di creare confusione ma anche di diffondere informazioni sbagliate.

Un caso emblematico riguarda un articolo su Valve: Google ha sintetizzato la notizia con il titolo “La Steam Machine di Valve assomiglia a una console, ma non aspettatevi che venga venduta allo stesso prezzo”, aggiungendo dettagli inesistenti sul prezzo del prodotto, mai annunciato dall’azienda.

In un altro esempio l’AI ha generato il titolo “le schede grafiche di AMD superano quelle di Nvidia”, suggerendo un sorpasso tecnologico inesistente: l’articolo originale parlava semplicemente di un rivenditore tedesco che, nell’arco di una settimana, aveva venduto più GPU AMD che NVIDIA. In altri casi, i titoli risultano troncati, privi di parole finali o semanticamente incoerenti, al punto da diventare incomprensibili.

Errori gravi e problemi di trasparenza

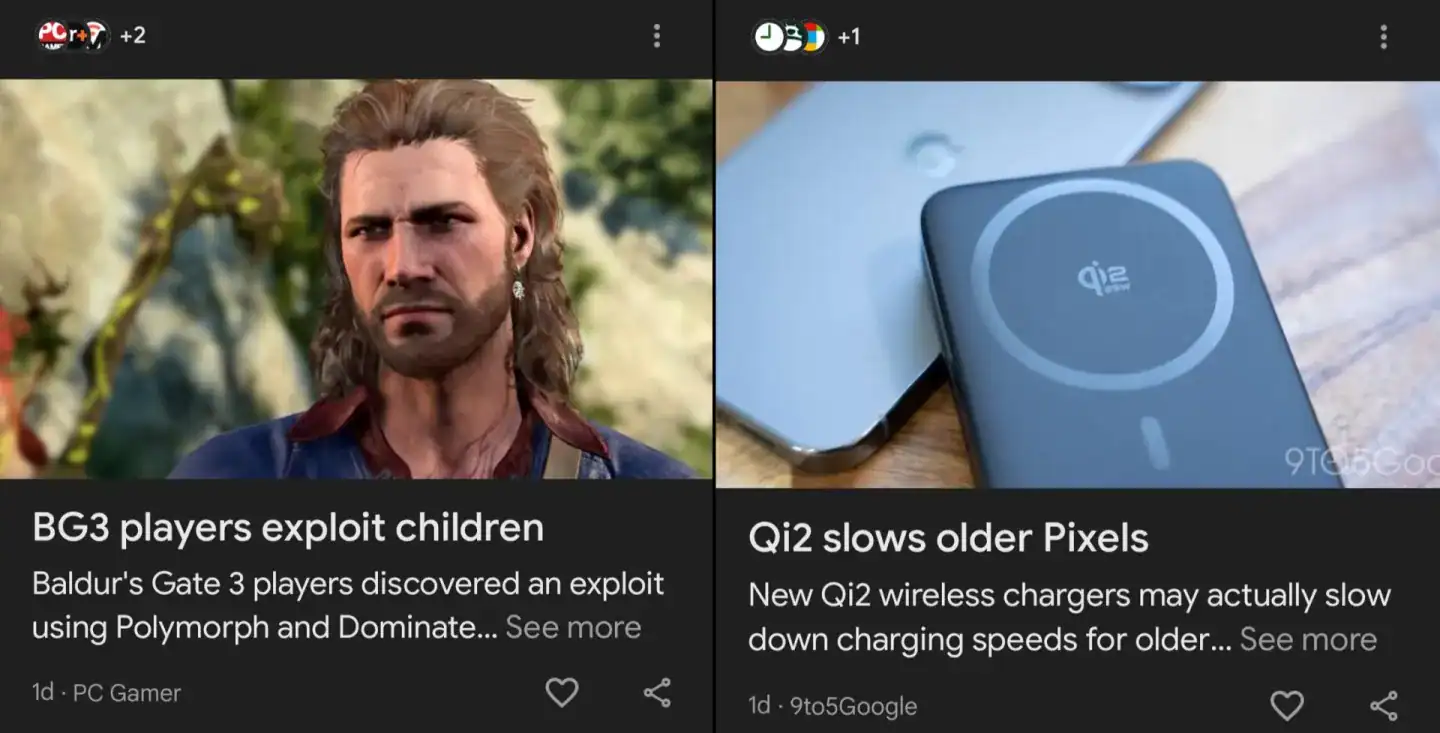

Oltre alle imprecisioni, sono emersi esempi più preoccupanti, in cui l’AI ha generato affermazioni prive di fondamento e potenzialmente allarmistiche, come un titolo secondo cui i giocatori di Baldur’s Gate 3 “sfruttassero i bambini”. Nessun elemento dell’articolo originale supportava una simile dichiarazione.

In altri casi, i titoli sono risultati completamente privi di senso — “Backup agricolo categoria uno” o “Il dibattito sull’etichettatura AI si scalda” — suscitando perplessità tra lettori e redazioni, che si trovano associati a contenuti che non hanno scritto.

Ulteriore elemento critico riguarda la trasparenza: Google specifica che i titoli sono “Generati da un’IA che può commettere errori”, ma tale avviso compare soltanto dopo aver cliccato sul pulsante “Vedi altro”. Ciò significa che l’utente che scorre il feed può attribuire le inesattezze alla testata giornalistica, non immaginando che siano frutto di un processo automatizzato di Big G.

Questa dinamica rischia di danneggiare la credibilità degli editori, che già da tempo segnalano come i sistemi di raccomandazione delle piattaforme influenzino in modo significativo la percezione delle notizie.

Google ha spiegato che si è trattato di un esperimento limitato, rivolto a un sottoinsieme di utenti, e che l’obiettivo è migliorare la fruibilità del feed. Tuttavia, numerosi editori hanno criticato l’iniziativa, sostenendo che non vi sia alcun bisogno di “semplificare” i titoli e che una simile intermediazione automatica comporta rischi maggiori rispetto agli eventuali benefici.

Una questione più ampia

Gli episodi riportati confermano le difficoltà ancora presenti nei modelli di intelligenza artificiale generativa nel trattare informazioni in modo coerente e affidabile. Non è la prima volta che Google viene criticata per risultati distorti o assurdi prodotti dall’AI: lo scorso anno, ad esempio, uno dei suoi sistemi suggeriva di “mangiare delle rocce di tanto in tanto” per migliorare la digestione, o di mettere “la colla sulla pizza” per far aderire meglio gli ingredienti.

Questi incidenti alimentano il dibattito sulla qualità dell’informazione mediata da algoritmi e sull’opportunità di delegare parti del processo editoriale a sistemi automatici. Sebbene le aziende tecnologiche continuino a presentare tali strumenti come soluzioni per migliorare l’esperienza utente, le sperimentazioni attuali evidenziano come sia necessario un controllo molto più rigoroso, soprattutto quando l’output può alterare la percezione di notizie sensibili.